Дата-центр без потерь электроэнергии

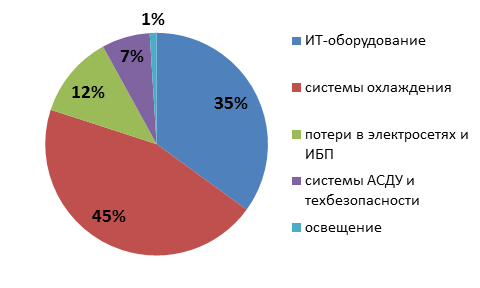

Высокие счета за электроэнергию являются главной статьей расходов для владельцев дата-центров. Современные центры обработки данных (ЦОД) потребляют около 1–2% электричества, вырабатываемого в мире. «Мозгом» дата-центра, который выполняет полезные вычисления, являются серверы, однако на них приходится лишь треть энергии, подведенной к площадке.

Наиболее «прожорливой» является система холодоснабжения ЦОД, реализованная по наиболее распространенной и классической на сегодняшний день схеме – на чиллерах или прецизионных кондиционерах с прямым расширением (DX -системы). При таком подходе на охлаждение приходится 45% энергозатрат. Без систем контроля температуры обойтись нельзя, так как в процессе работы вычислительные ядра серверов выделяют много тепла, и его своевременный отвод необходимо обеспечить, чтобы ИТ-оборудование не вышли из строя в результате перегрева. Еще не менее 12% энергии в ЦОД теряется при распределении в электросетях и в источниках бесперебойного питания (ИБП). Кроме того, часть электроэнергии уходит на работу автоматизированной систему диспетчерского управления (АСДУ).

Энергопотребление ЦОД до внедрения фрикулинга и FCC

Источник: RedSys, 2015

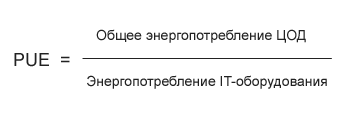

Экономия на охлаждении

Поскольку высокие операционные издержки, в первую очередь, обусловлены потребностями инженерных систем, одной из главных технических характеристик современных ЦОД является коэффициент энергоэффективности PUE, который равен отношению общего энергопотребления ЦОД к потребностям ИТ-оборудования. Этот показатель отражает, насколько много энергии тратится на работу обслуживающих инженерных комплексов.

Для современных дата-центров хороший средний показатель PUE cоставляет 1,2-1,4, однако, как показал опыт Facebook, который построил экспериментальный ЦОД в местечке Прайнвилль в штате Орегон, значение коэффициента энергоэффективности можно снизить до рекордных 1,05-1,1. Какие технологии необходимо внедрить, чтобы максимально снизить счет за электропотребление систем охлаждения, на которые приходится большая часть поставляемой в ЦОД энергии?

Технологии, используемые для экономии электроэнергии при охлаждении:

- системы полного свободного охлаждения FFC (full free-cooling system)

- чиллеры с функцией свободного охлаждения

- адиабатическое охлаждение

- технология разделения холодных и горячих коридоров и оптимизация воздушных потоков

- двигатели с электронными коммутаторами и спиральные компрессоры

Воздух с улицы

Один из наиболее распространенных подходов – применение оборудования с функцией «фрикулинга», то есть использование естественного холодного наружного воздуха.

Россия обладает уникальными климатическими возможностями для реализации этого подхода.

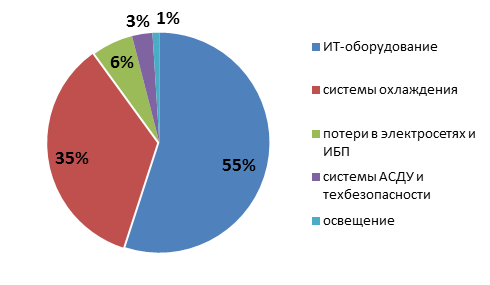

Благодаря длительному холодному периоду в течение до полугода, чиллеры с функцией свободного охлаждения («фрикулинг») могут обеспечивать холодоснабжение ЦОД без включения компрессора – наиболее энергопотребляющего элемента системы, работа которого, в зависимости от конфигурации и нагрузки системы, может потребоваться только выше 5 С 0. Как показывает практика, применение чиллеров с функцией свободного охлаждения позволяет экономить до 40% электроэнергии по сравнению решениями без данной функции. Энергоэффективность (PUE среднегодовой) для России в таких решениях может достигать порядка 1,3 -1,4 в зависимости от конфигурации решения, климатической зоны и принятых температурных параметров в ЦОД.

Еще более экономичными являются системы FFC (полного свободного охлаждения). В основе данного решения заложен принцип теплообмена между холодным наружным воздухом и воздухом, циркулирующем в ЦОД, который происходит через промежуточный роторный теплообменник (рекуператор). Таким образом, уличный воздух не поступает непосредственно в ЦОД, а через роторный теплообменник охлаждает воздух внутри до требуемой температуры, регулирование температуры в дата-центре при этом производится изменением скорости вращения роторного теплообменника.

В России данную технологию активно анедряет фирма Ayaks Engineering, которая обладает собственным запатентованным решением. Данная схема позволяет использовать для охлаждения оборудования в ЦОД уличный воздух до +22 С 0, при более высоких температурах в состав решения включаются контуры адиабатического охлаждения и компрессорный фреоновый модуль DX. По данным Ayaks Engineering, применение данного решения обеспечивает экономию электроэнергии на охлаждение ЦОД до 60 % относительно классических систем и среднегодовой PUE до 1,16.

Схема установки FFC (c сайта Ayaks Engineering)

Источник: Ayaks Engineering, 2015

Приведенный в начале пример ЦОД Facebook в Прайнвилль также построен на принципе полного свободного охлаждения, но без роторного рекуператора - такую схему называют прямой фрикулинг (прямое свободное охлаждение). В упрощенном виде это приточно-вытяжная вентиляционная установка, оснащенная секциями фильтров, подогрева и осушения воздуха и адиабатического охлаждения, предназначенными для очистки и подготовки наружного воздуха, подаваемого непосредственно к серверному оборудованию. Эта схема является наиболее энергоэффективной, однако она непроста в реализации из-за необходимости тщательной фильтрации наружного воздуха от пыли и примесей, а также из-за сложностей контроля влажности. Также как и вышеупомянутую систему FFC с роторным рекуператором, такую схему охлаждения применяют, как правило, при новом строительстве ЦОД. Это связано и с размерами самих установок и с необходимостью воздуховодами доставлять холодный воздух в зону серверных шкафов, а это чаще всего требует определённых архитектурных и конструктивных решений по зданию ЦОД, что не всегда можно сделать при реконструкции существующего здания.

Энергопотребление в ЦОД c функцией фрикулинга и FCC

Источник: RedSys, 2015

Охлаждение с помощью воды

Еще один способ охлаждения воздуха в ЦОД, уже упомянутый ранее в решениях Ayaks Engineering, позволяющий минимизировать расходы на энергию, получил название адиабатического охлаждения. В этом случае для снижения температуры используется вода, которая обладает большой теплоемкостью. Принцип действия систем адиабатического охлаждения состоит в распылении воды в виде мельчайших капель, при этом испарение происходит с потреблением тепла и соответствующим понижением температуры воздуха.

Различают два вида построения систем адиабатического охлаждения - прямое DEC (Direct Evaporative Cooling) и косвенное IEC (Indirect Evaporative Cooling). Прямое адиабатическое охлаждение предусматривает распыление мелкодисперсной воды на входе в вентиляционную установку (приточный воздух), косвенное адиабатическое охлаждение предусматривает распыление воды со стороны вытяжки. Прямое адиабатического охлаждение реализовано в ЦОД Facebook в Прайнвилль. Примером косвенного адиабатического охлаждения является распылении воды возле теплообменных поверхностей (радиаторов) сухих градирен или чиллеров.

Решения с косвенным адиабатическим охлаждением есть у всех ведущих производителей климатического оборудования и в общем случае представляет собой систему трубопроводов высокого давления с распылительными форсунками, насосные агрегаты, станцию водоподготовки и автоматическую систему управления. Наибольший эффект адиабатическое охлаждение будет давать в сухом теплом климате, при повышении влажности наружного воздуха (более 60%), эффективность такого подхода начинает снижаться, и при влажности наружного воздуха близкой к 100% (например в дождь) эта технология перестает работать. Экономия электроэнергии от применения систем полного свободного охлаждения совместно с адиабатическим охлаждением по отношению к классическим системам холодоснабжения на чиллерах или DX-системам может достигать 60% -90% в зависимости от региона расположения ЦОД, однако в данных системах появляется еще одна статья расходов – вода, и затраты на нее также надо учитывать.

Традиционный подход

При сохранении традиционных систем охлаждения, тем не менее, также существует несколько способов повысить эффективность инженерных систем и снизить PUE. Один из подходов заключается в изоляции горячих и холодных коридоров. По оценке компании Schneider Electric, изоляция горячего коридора вместо холодного поможет ежегодно экономить около 43% энергии, используемой системой охлаждения, что соответствует снижению показателя PUE на 15%. Также, независимо от выбранной технологии необходимо не забывать о том, что все решения по энергоэффективности могут стать бесполезными, если в серверных шкафах не будет решен вопрос об исключении смешивания потоков горячего и охлажденного воздуха. Для этого необходимо устанавливать заглушки на свободных от оборудования юнитах в серверном шкафу.

Другой распространенный вариант экономии в системах охлаждения представляют собой применение вентиляционного оборудования и кондиционеров с ЕС-двигателями (электронно-коммутируемый двигатель) и спиральных компрессоров Scroll Digital™ в чиллерах. Основное достоинство этих решений в возможности регулировать свою производительность в широком диапазоне, в зависимости от текущей нагрузки, что обеспечивает до 30% экономии электроэнергии. Собственно, применение такого оборудования (с эффективным регулированием производительности) стало уже практически стандартом при построении любого ЦОД.

Экономия на ИТ-оборудовании

Вторая крупная статья расходов на энергию связана с потребностями непосредственно ИТ-оборудования. Известно, что вычислительные мощности дата-центр очень редко бывают загружены максимально, то есть получается, что часть ИТ-оборудования всегда работает «вхолостую». Как заставить инфраструктуру ЦОД работать более эффективно?

Прежде всего, оптимизировать эту строку бюджета можно за счет более эффективного использования имеющихся серверов за счет внедрения средств виртуализации, которые позволяют представить физический сервер в виде виртуальных машин. Ранее, под каждую задачу/клиента дата-центр выделял отдельный сервер, при этом загрузка большую часть времени могла быть низкой. После виртуализации клиенты пользуются виртуальными машинами, которые могут работать на одном физическом сервере, тем самым уплотняя загрузку полезных мощностей, при этом простаивающие ресурсы становится возможным временно отключить от питания.

Модульный принцип

Выше были рассмотрены технологии, правильное применение которых может повысить энергоэффективность ЦОД (PUE) по отдельным инженерным и ИТ-системам. Но есть еще один подход к повышению PU более высокого уровня, который распространяется на все системы дата-центра. Он основан на модульном принципе построения ЦОД. Данный подход позволяет более четко соблюсти баланс между ИТ-нагрузкой и обслуживающей ее инженерной инфраструктурой, что, в конечном счете, отражается на энергоэффективности. Модульный принцип построения и модульные ЦОДы можно встретить на рынке в двух вариантах.

Во-первых, могут быть использованы стандартизированные модули-контейнеры с предустановленным производителем холодильными, электросиловыми установками, конструктивами серверных стоек и другим технологическим оборудованием. Такой подход позволяет достаточно быстро построить ЦОД необходимой мощности, собирая его из стандартных «кубиков». Подобные решения есть у таких крупных производителей оборудования для ЦОД как Schneider Electric, Emerson, Huawei и т.д. Такой способ строительства ЦОД возможен как в «чистом поле», так и при приспособлении (реконструкции) для ЦОД какого-либо здания.

Второй вариант предполагает использование инженерного оборудования любого производителя, а модульный принцип реализуется архитектурно-планировочными и инженерно-технологическими решениями. При этом серверный зал выделяется в отдельный автономный модуль, который имеет полный набор необходимых инженерных систем. По мере роста потребностей этот модуль тиражируется. Данный способ строительства ЦОД, как правило, применяется при новом строительстве в «чистом поле».

Различие этих вариантов, по сути, касается в основном больше способа возведения и типа строительного конструктива здания ЦОД, в первом варианте - это готовые модули, произведенные на заводе-изготовителе и собранные воедино на площадке, во втором варианте ЦОД может быть реализован и как капитальное строение, рассчитанное на 50-летний срок эксплуатации.

Самое важное, что обеспечивает модульный подход – это соблюдение баланса между ИТ-нагрузкой и инженерной инфраструктурой и возможность быстрого наращивания и масштабирования стандартизованными модулями.

Павел Лебедев